Mở rộng cụm AI cho các doanh nghiệp Big Tech

AI đang phát triển với tốc độ chưa từng có, tạo ra nhu cầu cấp thiết về các trung tâm dữ liệu mạnh mẽ và hiệu quả hơn. Để đáp ứng nhu cầu này, các quốc gia và các doanh nghiệp đang tăng cường đầu tư vào cơ sở hạ tầng AI.

|

Theo Forbes, chi tiêu cho AI của các công ty công nghệ lớn sẽ đạt hơn 250 tỷ USD vào năm 2025, phần lớn dành cho đầu tư hạ tầng. Tới năm 2028, tổng đầu tư toàn cầu vào hạ tầng AI, bao gồm các trung tâm dữ liệu, mạng và phần cứng sẽ đạt 423 tỷ USD .

Tuy nhiên, những đổi mới sáng tạo nhanh chóng của AI cũng tạo ra áp lực chưa từng có lên mạng lưới trung tâm dữ liệu. Chẳng hạn, bài viết gần đây của Meta cho thấy cụm huấn luyện mô hình Llama 3 405B cần hơn 700 TB bộ nhớ và 16.000 bộ xử lý đồ họa (GPU) NVIDIA H100 trong giai đoạn trước huấn luyện. Epoch AI ước tính rằng tới năm 2030, các mô hình AI sẽ cần sức mạnh tính toán gấp 10.000 lần so với các mô hình hàng đầu hiện nay.

Sự trỗi dậy của các cụm AI

Cụm AI (AI clusters) là mạng lưới tài nguyên điện toán lớn, được kết nối chặt chẽ để xử lý các ứng dụng AI.

Khác với các cụm máy tính truyền thống, các cụm AI được tối ưu hóa cho các tác vụ như huấn luyện mô hình AI, suy luận và phân tích theo thời gian thực. Các cụm AI này sử dụng hàng nghìn GPU, kết nối tốc độ cao và mạng có độ trễ thấp để đáp ứng các yêu cầu khổng lồ về thông lượng dữ liệu và tính toán của AI.

Xây dựng các cụm AI

Về cơ bản, cụm AI vận hành như một mạng lưới thu nhỏ. Xây dựng cụm AI đồng nghĩa với kết nối các GPU để tạo mạng điện toán hiệu năng cao, có thể truyền dữ liệu liền mạch giữa các GPU. Vì được thực hiện nhờ sự phối hợp lâu dài giữa hàng nghìn GPU, quá trình huấn luyện phân tán cần có kết nối mạng ổn định.

Các thành phần chính của cụm AI

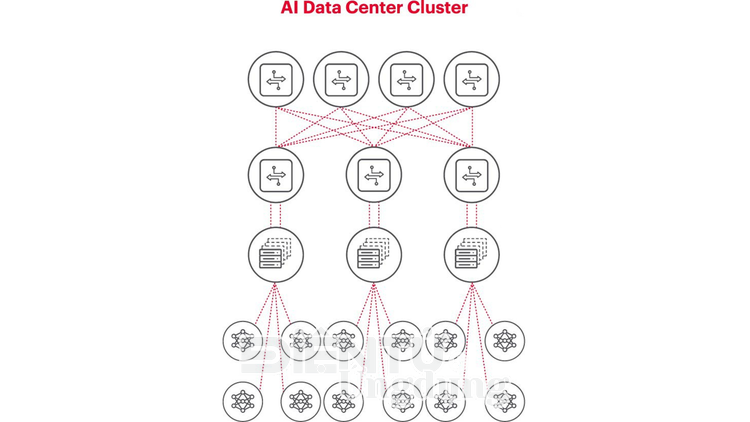

Các cụm AI bao gồm nhiều thành phần thiết yếu, như được thể hiện trong hình 1.

|

| Hình 1: Cụm trung tâm dữ liệu AI |

- Các nút (node) tính toán là bộ não của cụm AI, với hàng nghìn GPU kết nối với các thiết bị chuyển mạch trên giá máy. Khi độ phức tạp của bài toán tăng lên, nhu cầu về GPU cũng tăng theo.

- Kết nối tốc độ cao như Ethernet cho phép truyền dữ liệu nhanh giữa các nút tính toán.

- Cơ sở hạ tầng mạng bao gồm phần cứng mạng và các giao thức hỗ trợ truyền dữ liệu giữa hàng nghìn GPU trong thời gian dài.

Mở rộng cụm AI

Các cụm AI mở rộng quy mô để đáp ứng khối lượng công việc và mức độ phức tạp ngày càng tăng của AI. Cho tới nay, do hạn chế về băng thông mạng, độ trễ và một số yếu tố khác, các cụm AI chỉ hỗ trợ được khoảng 30.000 GPU. Tuy nhiên, dự án siêu máy tính Colossus của xAI đã phá vỡ rào cản này khi nâng quy mô cụm lên hơn 100.000 GPU NVIDIA H100, một bước đột phá chỉ có thể có được nhờ những tiến bộ trong công nghệ mạng và bộ nhớ.

Các thách thức chính khi mở rộng quy mô

Trong bối cảnh các mô hình AI phát triển lên tới hàng ngàn tỷ tham số, việc mở rộng quy mô các cụm AI gặp vô số rào cản cả kỹ thuật cũng như tài chính.

Các thách thức về mạng

Các GPU có thể thực hiện hiệu quả các phép toán song song. Tuy nhiên, nếu một GPU không có đủ dữ liệu cần thiết hoặc bị trễ trong khi hàng nghìn - thậm chí hàng trăm nghìn GPU - cùng xử lý một tác vụ trong một cụm AI, tất cả GPU khác đều bị ảnh hưởng. Độ trễ gói tin kéo dài hoặc tình trạng mất gói tin do mạng bị tắc nghẽn có thể dẫn đến việc truyền lại gói tin, làm tăng đáng kể thời gian hoàn thành công việc (JCT) và khiến các GPU trị giá hàng triệu USD rơi vào trạng thái chờ.

Ngoài ra, các ứng dụng AI gia tăng đáng kể lưu lượng hướng đông-tây (dữ liệu di chuyển giữa các nút trong trung tâm dữ liệu), có thể dẫn đến tình trạng tắc nghẽn mạng và các vấn đề về độ trễ nếu cơ sở hạ tầng mạng truyền thống không được tối ưu hóa cho các ứng dụng này.

Các thách thức về kết nối

Khi các cụm AI mở rộng, các kết nối truyền thống có thể không đáp ứng được nhu cầu về thông lượng. Để tránh tình trạng tắc nghẽn, các tổ chức phải nâng cấp tốc độ lên kết nối, bằng các giải pháp như 800G hoặc thậm chí 1.6T. Tuy nhiên, không dễ triển khai và xác nhận các liên kết tốc độ cao này để đáp ứng các yêu cầu khắt khe của các ứng dụng AI. Các tuyến liên kết nối tiếp tốc độ cao này cần được tinh chỉnh và đo kiểm kỹ lưỡng để bảo đảm tính toàn vẹn của tín hiệu, tỷ lệ bit lỗi thấp và hiệu năng sửa lỗi trước (FEC) đáng tin cậy. Mọi bất ổn trong các tuyến liên kết nối tiếp tốc độ cao có thể làm suy giảm độ chính xác và tốc độ huấn luyện AI. Các doanh nghiệp cần các hệ thống đo kiểm chính xác và hiệu quả cao để xác nhận hợp chuẩn trước khi triển khai.

Các thách thức tài chính

Tổng chi phí mở rộng các cụm AI thường cao hơn chi phí mua GPU. Các tổ chức còn phải tính đến chi phí cấp nguồn, làm mát, thiết bị mạng và hạ tầng trung tâm dữ liệu nói chung. Tuy nhiên, các ứng dụng AI có liên kết tốt hơn và hiệu năng mạng tối ưu có thể chạy nhanh hơn, rút ngắn chu kỳ huấn luyện và giải phóng nguồn lực cho các tác vụ bổ sung. Mỗi ngày huấn luyện được rút ngắn có thể quy đổi thành giá trị tiết kiệm chi phí đáng kể, khiến rủi ro tài chính cao tương đương rủi ro kỹ thuật.

Các thách thức về xác nhận hợp chuẩn

Để tối ưu hóa hiệu năng mạng của các cụm AI cần thực hiện đo kiểm và đối chuẩn hiệu năng của nền tảng (fabric) mạng và kết nối giữa các GPU. Tuy nhiên, việc xác nhận hợp chuẩn các linh kiện và hệ thống này gặp nhiều khó khăn do mối quan hệ phức tạp giữa phần cứng, thiết kế kiến trúc và các đặc điểm linh động của ứng dụng.

Trong xác nhận hợp chuẩn, có ba vấn đề chung nhất.

Thứ nhất: Những cản trở khi triển khai trong môi trường lab

Chi phí phần cứng AI cao, tính khả dụng hạn chế của thiết bị và thiếu kỹ sư mạng khiến việc nhân rộng toàn phần trở nên không thực tế. Ngoài ra, môi trường phòng thí nghiệm thường có những hạn chế về không gian, nguồn điện và nhiệt độ khác với điều kiện thực tế của trung tâm dữ liệu.

Thứ hai: Tác động đến hệ thống sản xuất

Việc đo kiểm trên hệ thống sản xuất có thể gây gián đoạn, ảnh hưởng đến các hoạt động AI trọng yếu.

Thứ ba: Ứng dụng AI phức tạp

Bản chất đa dạng của các ứng dụng AI và tập dữ liệu khác nhau đáng kể về quy mô và mô hình giao tiếp, khiến khó tái tạo nhất quán các vấn đề và đối chuẩn.

Trong quá trình AI định hình các trung tâm dữ liệu, cần chuẩn bị cơ sở hạ tầng mạng sẵn sàng cho tương lai để theo kịp các công nghệ và tiêu chuẩn đang nhanh chóng phát triển. Các giải pháp mô phỏng tiên tiến của Keysight cho phép xác nhận hợp chuẩn toàn diện các giao thức mạng và tình huống vận hành trước khi triển khai, mang đến lợi ích trọng yếu cho quá trình này.

Thông tin chi tiết về chủ đề này được cung cấp bổ sung trong sách trắng của Keysight, Cải thiện khả năng mở rộng trong cụm trung tâm dữ liệu AI.

Emily Yan là giám đốc tiếp thị sản phẩm tại Keysight Technologies. Trước Keysight, cô đã làm việc trong lĩnh vực AI và tiếp thị dữ liệu lớn trong nhiều ngành nghề. Emily có bằng MBA của Đại học Columbia và bằng cử nhân của Đại học California, Berkeley chuyên ngành toán ứng dụng và kinh tế. |

Emily Yan