Deepfake - mối đe dọa tiềm tàng về tin giả, lừa đảo và tống tiền

Nguồn ảnh: Tuoitre.

Deepfake là gì?

Theo Kaspersky cho biết, deepfake là từ được ghép lại từ hai chữ "deep" trong deep-learning (học sâu) và "fake" (lừa dối). Deepfake có thể hiểu là một phương pháp trí tuệ nhân tạo (AI) tiên tiến sử dụng nhiều lớp thuật toán máy học để trích xuất dần dần các tính năng cấp cao hơn từ một đầu vào có lượng dữ liệu thô, nó có khả năng học hỏi từ dữ liệu phi cấu trúc - chẳng hạn như khuôn mặt người. Nó thậm chí có thể thu thập dữ liệu về các chuyển động vật lý của con người.

Dữ liệu hình ảnh còn được xử lý tiếp để tạo video deepfake thông qua mạng lưới đối thủ sáng tạo (GAN), đây là một loại hệ thống các máy học chuyên dụng. Hai mạng thần kinh có thể được sử dụng để cạnh tranh với nhau trong việc học các đặc điểm đã có trong kho dữ liệu thông tin nhằm mục đích huấn luyện AI (Ví dụ: Ảnh chụp khuôn mặt) và sau đó tạo dữ liệu mới có cùng đặc điểm ("ảnh" mới).

Khả năng học hỏi của các AI luôn được kiểm tra liên tục và so sánh với dữ liệu gốc nhằm mục đích huấn luyện, chính vì vậy mà hình ảnh được AI "làm giả" ngày càng trở nên thuyết phục. Điều này khiến cho deepfake đang là mối đe dọa lớn hơn bao giờ hết. Không chỉ dừng lại ở hình ảnh, một số công nghệ deepfake đã có thể được sử dụng để giả giọng nói.

Mối nguy hại của Deepfake trong lừa đảo, tống tiền và tung tin giả

Rất khó để có thể giải thích cụ thể về phương thức hoạt động của deepfake theo hướng kỹ thuật. Nhưng có thể hiểu đơn giản rằng, deepfake với khả năng học hỏi dữ liệu khuôn mặt, hình ảnh và cả giọng nói của con người. Việc sử dụng deepfake để tống tiền, chiếm đoạt tài sản đang có xu hướng ngày một gia tăng.

Chỉ bằng giọng nói deepfake của người đứng đầu công ty đó với yêu cầu chuyển tiền khẩn cấp, các đối tượng lừa đảo đã khiến CEO của một công ty năng lượng bị lừa 243.000 USD. Sự giả mạo quá thuyết phục khiến CEO không kịp nghi ngờ và không nghĩ đến việc kiểm tra chéo, tiền không được chuyển đến trụ sở chính mà đến một tài khoản ngân hàng bên thứ ba. CEO chỉ trở nên nghi ngờ khi "sếp" của anh ta yêu cầu thêm một lệnh chuyển tiền khác. Kẻ giả mạo đã bị phát hiện, nhưng đã quá muộn để lấy lại số tiền 243.000 USD vừa chuyển trước đó.

Tổng tiền bằng các video khiêu dâm là một viễn cảnh mà dường như ai cũng có thể nghĩ đến khi deepfake được ra đời. Cụ thể, công cụ này đã được sử dụng để tống tiền các nữ phóng viên và nhà báo, trường hợp của Rana Ayyub ở Ấn Độ, nữ phóng viên này đã bị ghép mặt vào các video khiêu dâm, sau đó kẻ gian đã sử dụng các video giả này để tống tiền cô.

Không dừng lại ở việc sử dụng deepfake để tống tiền, các đối tượng lừa đảo còn sử dụng công nghệ này để tung các tin tức giả về chính trị hay những người nổi tiếng.

Nguồn ảnh: Opendemocracy.

Đơn cử một ví dụ thể hiện sự nguy hiểm của deepfake là video do nam diễn viên Jordan Peele thực hiện, đội ngũ kỹ thuật viên đã sử dụng cảnh quay thực của ông Barack Obama kết hợp với kỹ thuật dựng video và "deepfake" tạo ra một đoạn phát ngôn giả, trong video đó ông Obama dùng những lời lẽ không tốt đẹp để nói về ông Trump.

Ngay sau đó, nam diễn viên Jordan Peele đã đăng tải hai nửa của video được hợp nhất trông như thế nào, với mục đích cảnh báo mọi người về những thủ đoạn tinh vi nhằm tạo ra tin giả mà chúng ta có thể gặp trên môi trường Internet. Được biết, đội ngũ của nam diễn viên đã mất khoảng 60 tiếng đồng hồ để tạo ra video giả nhưng trông rất thực này.

Nguồn ảnh: Timeforkids.

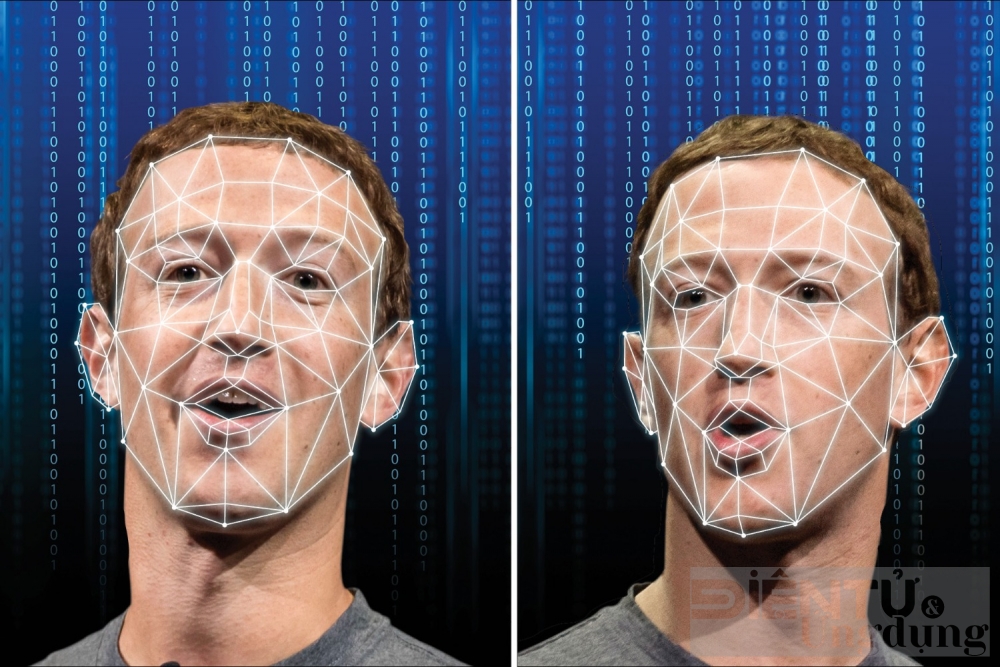

Hay như Mark Zuckerberg, người sáng lập mạng xã hội Facebook cũng "được" deepfake làm giả, từ một bài phát biểu đơn thuần, deepfake đã tạo ra một video mà Mark Zuckerberg thừa nhận Facebook đánh cắp dữ liệu người dùng và đang kiểm soát tương lai. Mặc dù ở đoạn video này, AI giả giọng ông Mark Zuckerberg không quá giống nhưng cũng rất khó để nhận ra.

Trước đó, vào năm 2017, một công ty khởi nghiệp AI có tên Lyrebird đã phát hành bản sao giọng nói của những vị lãnh đạo Mỹ như ông Trump, ông Obama và bà Hilary Clinton. Kể từ đó, chất lượng đã được cải thiện rất nhiều và thậm chí ứng dụng Lyrebird còn cho phép công chúng sử dụng công khai.

Tất cả những ví dụ nêu trên đều là những đoạn video chỉn chu với độ phân giải, độ chi tiết cao, nhưng nếu bạn nghĩ hình ảnh càng sắc nét thì càng dễ lừa đảo có lẽ bạn đã lầm. Bà Nancy Pelosi từng là nạn nhân trong một video giả với những phát ngôn như một người đang say rượu, video giả này có chất lượng cực kỳ kém nhưng đã nhanh chóng thu hút hàng triệu lượt xem trên mạng xã hội, buộc bà Nancy Pelosi phải lên tiếng đính chính ngay sau đó.

Công nghệ ngày càng phát triển và việc tiếp cận deepfake trở nên đơn giản và chi phí thực hiện ngày càng rẻ hơn, khiến mức độ nguy hiểm tăng lên mỗi ngày. Nếu chúng ta không được trang bị đủ kiến thức và thông tin, rất khó để nhận ra deepfake.

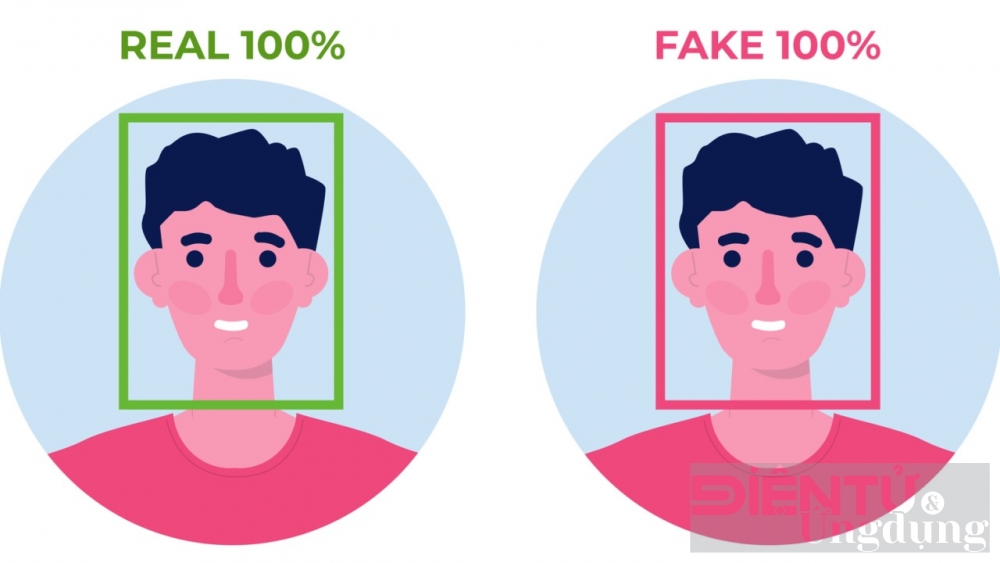

Nguồn ảnh: Searchenginejournal.

Lời khuyên của các chuyên gia để tự bảo vệ trước deepfake?

Để đối phó với những chiêu trò lửa đảo sử dụng công nghệ deepfake, các chuyên gia về bảo mật đã đưa ra những lời khuyên nhằm phòng tránh trước các tính huống xấu có thể xảy ra, đặc biệt là việc nâng cao bảo mật các tài khoản trực tuyến.

Tin tưởng nhưng vẫn phải xác minh: Nếu nhận được một đoạn tin nhắn thoại với mục đích vay tiền hoặc mượn tài sản cá nhân... Dù cho giọng nói nghe rất quen thuộc và cực kỳ giống thật, tốt nhất bạn hãy gọi điện thoại cho người gửi tin nhắn để xác minh người đó có thực sự gửi yêu cầu vay/mượn tài sản bằng tin nhắn thoại.

Đừng vội truy cập bất kỳ đường link nào: Khi được người thân gửi cho một đường link với những cấu trúc lạ, đừng vội vàng nhấp vào đường link/nút đó. Rất có thể đó là một cái bẫy được đưa ra để kẻ lừa đảo có thể chiếm đoạt tài khoản trực tuyến của bạn. Hãy tìm cách xác minh lại với người đã gửi tin nhắn cho bạn.

Hãy chú ý vào những điều nhỏ nhất: Nếu nhận được một cuộc gọi chuyển tiền hoặc video call với nội dung chuyển tiền, dù là người thân thiết, bạn vẫn hãy xem kỹ số điện thoại, email hoặc tài khoản có trùng hợp với người đang thực hiện yêu cầu hay không. Thông thường các đối tượng sẽ yêu cầu chuyển tiền sang một tài khoản bên thứ ba hoặc sang một tài khoản có tên gần tương tự.

Hạn chế quyền truy cập vào giọng nói và hình ảnh của bạn: Để có thể tạo ra hình ảnh và âm thanh giả những kẻ lừa đảo sẽ cần các bản ghi âm, hình ảnh hoặc cảnh quay để tạo ra những sản phẩm giả. Do đó, hãy hạn chế chia sẻ dữ liệu hình ảnh, âm thanh trên mạng xã hội hoặc đặt tài khoản ở chế độ riêng tư, chỉ chấp nhận yêu cầu từ những người bạn tin tưởng.

Ngoài ra, một số các chuyên trang về bảo mật còn chỉ ra một số điểm để có thể phát hiện deepfake:

- Nhân vật nói liên tục, không chớp mắt

- Khẩu hình miệng không đồng bộ với lời nói

- Thay đổi tông màu da liên tục

- Ánh sáng bị thay đổi liên tục từ khung hình này sang khung hình tiếp theo

- Chuyển động giật cục, như một đoạn video lỗi

- Video có những sự nhấp nháy lạ thường

- Hiện lên các đồ vật kỹ thuật số trong hình ảnh

- Âm thanh và/hoặc video chất lượng thấp

Theo số liệu từ IBM, tính đến tháng 6/2019, số lượng video deepfake được phát hiện chỉ vỏn vẹn 3.000, tuy nhiên đến tháng 3/2020 đã có hơn một triệu video deepfake được lưu hành trên Internet.

Một nghiên cứu khác từ Deeptrace chỉ ra rằng, vào tháng 12/2018, đã có 15.000 video deepfake được ra đời. Con số này tăng lên 558.000 vào tháng 6/2019 và tăng vọt lên hơn một triệu vào tháng 2/2020.

Nghiên cứu của Deeptrace cho biết thêm, có đến 96% các video deepfake được tạo ra phục vụ các mục đích không hợp pháp. Những con số này đang báo động cho chúng ta về một viễn cảnh chẳng mấy tốt đẹp về thông tin giả, những chiêu trò lừa đảo,... áp dụng deepfake rất có thể sẽ tràn lan trên môi trường Internet.

(Bài đăng ấn phẩm in Tạp chí Điện tử và Ứng dụng số 02 tháng 04/2023)

Có thể bạn quan tâm

Chuyên gia kinh tế Sebastian Mallaby dự báo: OpenAI có nguy cơ phá sản trong năm 2028

AI

Singapore lập viện nghiên cứu đối phó thay đổi việc làm từ trí tuệ nhân tạo

Đổi mới sáng tạo

Hướng tới phát triển bền vững, HP và WWF-Việt Nam ký kết hợp tác chiến lược

Kết nối sáng tạo