Nvidia giới thiệu Chip AI mạnh nhất thế giới, tăng tốc 30 lần so với phiên bản trước

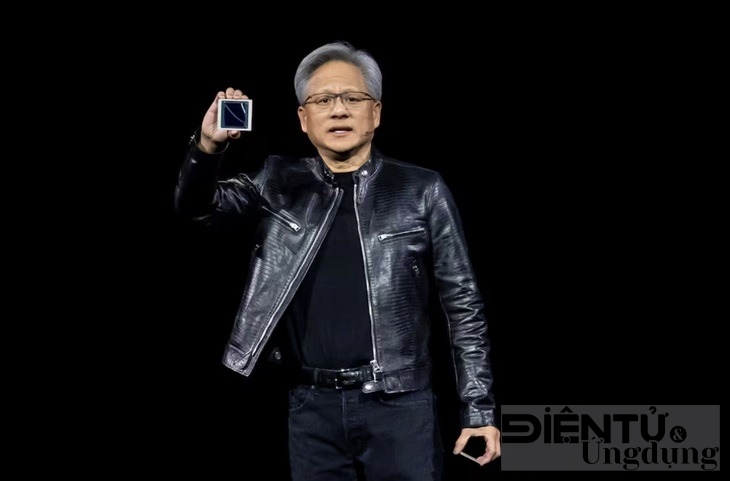

Chủ tịch Jensen Huang giới thiệu chip Blackwell B200 tại sự kiện thường niên diễn ra vào ngày 18-3 - Ảnh: BLOOMBERG.

Reuters đưa tin Nvidia vừa công bố loại chip AI mới mang tên Blackwell B200 tại hội nghị thường niên của công ty diễn ra vào ngày 18 tháng 3. Điểm đáng chú ý của Blackwell B200 là khả năng xử lý vượt trội so với phiên bản trước đó, Hopper H100.

Blackwell B200 sở hữu 208 tỉ bóng bán dẫn, cung cấp khả năng xử lý AI lên đến 20 petaflop (tức là 20 triệu tỉ phép tính mỗi giây). So với Hopper H100, số lượng bóng bán dẫn của Blackwell B200 đã tăng gấp đôi lên 80 tỉ, và khả năng xử lý cũng tăng lên gấp 5, lên đến 4 petaflop mỗi giây.

Chủ tịch Jensen Huang cho biết B200 có khả năng xử lý một số tác vụ nhanh gấp 30 lần so với H100, đồng thời giảm chi phí và tiêu thụ năng lượng lên đến 25 lần so với phiên bản trước.

" Hopper là một sản phẩm tuyệt vời, nhưng chúng ta cần một GPU lớn hơn", ông Huang nói.

Theo ông Huang, trước đây, một mô hình AI với 1.800 tham số cần đến 8.000 GPU và 15MW năng lượng. Nhưng giờ đây, mô hình đó chỉ cần 2.000 GPU B200 và 4MW để thực hiện cùng khối lượng công việc.

Nvidia hướng đến các khách hàng mua số lượng lớn bằng cách đóng gói nhiều chip thành một "siêu chip" gọi là GB200 NVL72. Bên trong gói là 72 chip AI, 36 bộ xử lý trung tâm và 600.000 bộ phận, cung cấp khả năng xử lý lên đến 1.440 petaflop hoặc 1,4 hexaflop.

Tuy Nvidia chưa công bố giá của B200 và GB200, nhưng hãng đã tiết lộ rằng các gigant công nghệ như Amazon, Google, Microsoft và Oracle sẽ sử dụng GB200 cho các trung tâm dữ liệu của họ.

Theo các nhà phân tích, H100 của Nvidia có giá từ 25.000 đến 40.000 USD mỗi đơn vị và toàn bộ hệ thống có giá lên tới 200.000 USD.

Bên cạnh B200, Nvidia còn giới thiệu phần mềm mới gọi là NIM. Bộ công cụ này cho phép người dùng dễ dàng kết hợp mô hình AI vào công việc cũng như nhiều mục đích khác.

Có thể bạn quan tâm

Trung Quốc tung năm mô hình AI mới, MiniMax vượt mặt DeepSeek trong mắt phố Wall

AI

Hơn 72 giờ 'tê liệt' internet tại Iran

Viễn thông - Internet

Ericsson vận hành thành công mạng 6G ngoài phòng thí nghiệm

Viễn thông - Internet