Huấn luyện LLM hiệu quả với ma trận AI tối ưu

| Lời tòa soạn: Khi các công ty công nghệ đổ hàng tỷ USD mua GPU để xây dựng AI mạnh hơn, họ đang bỏ qua yếu tố thực sự quyết định thành công: khả năng kết nối giữa các bộ xử lý. Nghiên cứu từ chuyên gia Heidi Garcia thuộc Keysight Technologies tiết lộ thực tế gây sốc: một GPU trị giá 40.000 USD có thể trở nên vô dụng nếu hệ thống mạng không theo kịp. Các mô hình AI hiện tại di chuyển hàng terabyte dữ liệu mỗi giây, đòi hỏi băng thông lên tới 1.6T Ethernet - con số khiến ngay cả mạng doanh nghiệp hàng đầu cũng lép vế. Vấn đề trở nên nghiêm trọng hơn khi Garcia chỉ ra bản chất đồng bộ của huấn luyện AI. Một GPU chậm khiến cả hệ thống hàng nghìn bộ xử lý phải ngừng hoạt động, biến việc đầu tư thiết bị đắt tiền thành lãng phí nếu thiếu ma trận AI phù hợp. Cuộc chơi AI đang thay đổi từ "ai có GPU nhiều nhất" sang "ai tối ưu toàn bộ hệ sinh thái". Khoảng cách giữa những gã khổng lồ công nghệ và phần còn lại sẽ ngày càng lớn, không chỉ vì GPU mà vì toàn bộ hạ tầng mạng phức tạp đằng sau mỗi mô hình AI tiên tiến. |

|

Cuộc chạy đua xây dựng các mô hình ngôn ngữ lớn (LLM) mạnh mẽ hơn đang ngày càng ráo riết, trong đó GPU và kiến trúc mô hình là các cấu phần quan trọng. Tuy nhiên, khi số lượng tham số của các mô hình có thể lên đến hàng trăm tỷ, khả năng truyền tải dữ liệu hiệu quả trở nên quan trọng như công suất tính toán mạnh mẽ. Mạng lưới này chính là đường trục hỗ trợ hiệu năng, hiệu suất và tỷ lệ hoàn vốn đầu tư (ROI) của việc huấn luyện AI.

Cơ sở hạ tầng hỗ trợ cần đáp ứng được yêu cầu của các hệ thống này. Cốt lõi của quá trình chuyển đổi này là ma trận AI: một lớp liên kết hiệu năng cao kết nối hàng nghìn GPU và NPU, thiết lập nền móng cho quá trình huấn luyện phân tán quy mô lớn.

Khác với các mạng Ethernet truyền thống chủ yếu dành cho lưu lượng phổ thông, các ma trận AI được thiết kế chuyên biệt để đáp ứng nhu cầu của các ứng dụng AI phân tán. Các đặc điểm chính của ma trận AI bao gồm khả năng mở rộng và tốc độ cao, dung lượng lớn cũng như kiểm soát tắc nghẽn. Khả năng mở rộng cao hỗ trợ mở rộng linh hoạt các máy chủ GPU, thiết bị chuyển mạch và các nút lưu trữ, tốc độ dữ liệu cao được tạo ra nhờ ứng dụng các công nghệ liên kết tốc độ cao và độ trễ thấp như 800G/1.6T Ethernet và giao thức RoCE.

Ngoài ra còn có kỳ vọng cho rằng mạng sẽ vận hành gần mức công suất tối đa, đảm bảo không mất dữ liệu khi truyền dẫn. Các hệ thống AI cần độ tin cậy cao để bảo đảm huấn luyện và triển khai chính xác mô hình. Cơ chế kiểm soát tắc nghẽn với công nghệ truy cập bộ nhớ Remote Directory Memory Access (RMDA) không mất dữ liệu đảm bảo phân phối dữ liệu được thực hiện đáng tin cậy, giảm rủi ro lỗi hoặc mất dữ liệu trong truyền dẫn.

Tầm quan trọng của ma trận AI trong huấn luyện LLM

|

| Heidi Garcia, Keysight Technologies |

Sự trỗi dậy nhanh chóng của huấn luyện mô hình ngôn ngữ lớn (LLM) đang định hình lại kỳ vọng đối với các mạng trung tâm dữ liệu. Kiến trúc mạng trung tâm dữ liệu truyền thống đang gặp khó khăn khi đáp ứng các nhu cầu thường xuyên thay đổi của các môi trường AI. Các môi trường này ưu tiên lưu lượng hướng nam bắc (người dùng tới máy chủ) và coi lưu lượng hướng đông tây (giữa các máy chủ) là lưu lượng thứ cấp. Tuy nhiên, quá trình huấn luyện AI đã đảo ngược phương trình này, đặc trưng bởi những luồng lưu lượng đột biến siêu lớn có entropy thấp. Quá trình này đòi hỏi khả năng truyền dữ liệu không tổn thất, siêu nhanh theo hướng đông tây với quy mô khổng lồ chỉ trong vài phần nghìn giây.

Ma trận AI đóng vai trò then chốt trong chi phí huấn luyện AI. Huấn luyện LLM là quá trình đồng bộ, đòi hỏi tất cả GPU phải phối hợp và hoàn thành đồng thời các chuỗi phép lặp (iteration). Những máy chủ GPU đắt tiền này có thể không được sử dụng đến nếu liên kết hay mạng chậm. Một khoảng trễ rất ngắn trong quá trình trao đổi dữ liệu có thể khiến cho hàng nghìn GPU phải ngồi chờ dữ liệu và làm gia tăng chi phí huấn liệu.

Mạng phục vụ ứng dụng AI phải mở rộng theo những cách khác với các mạng truyền thống. Ma trận AI cần mở rộng cả theo chiều ngang và chiều dọc, đồng thời quản lý thông lượng lưu lượng cao qua hàng nghìn nút với độ trễ tối thiểu và không mất gói dữ liệu.

Huấn luyện song song và Giao tiếp tập thể

Tối ưu hóa sử dụng tài nguyên điện toán là ưu tiên hàng đầu khi thiết kế cơ sở hạ tầng cho các ứng dụng huấn luyện mô hình AI hoạt động trong các chế độ hỗn hợp giữa nối tiếp và song song. Một số phép toán phải đợi các bước trước đó mới được bắt đầu thực hiện, nhiều phép toán khác có thể chạy song song, giúp giảm đáng kể thời gian huấn luyện bằng cách khai thác nhiều bộ xử lý.

Tuy nhiên, một trong những hạn chế phổ biến nhất trong huấn luyện quy mô lớn là dung lượng bộ nhớ của GPU, vì tất cả các kết quả trung gian phải được lưu trữ để cập nhật các tham số của mô hình. Để phân phối hiệu quả tải tính toán và bộ nhớ cần thiết, các chuyên gia đã phát triển một số kỹ thuật song song cho phép thực hiện tính toán đồng thời trên các nút khác nhau.

Để thực hiện quá trình song song hóa này cần chia khối lượng công việc tổng thể thành các tác vụ nhỏ hơn chạy đồng thời. Các tác vụ này sử dụng các thao tác kết nối tập thể - như all-reduce hoặc all-gather - để đồng bộ kết quả và duy trì sự chính xác của mô hình.

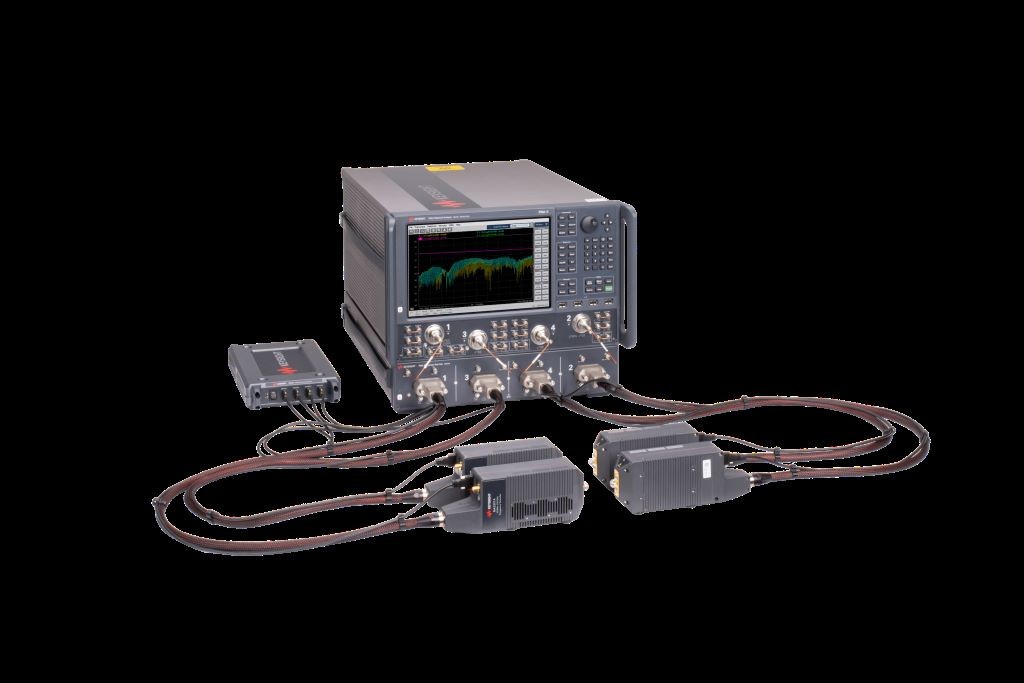

Cách kiểm thử và xác thực ma trận AI

Để đo lường chính xác hiệu năng của ma trận AI với các ứng dụng thực tế đòi hỏi khoản đầu tư tốn kém vào các hệ thống điện toán với GPU và card mạng (NIC) RDMA. Các nhà cung cấp và nhà mạng sử dụng những công cụ như Keysight Data Center Builder và bộ tạo lưu lượng Keysight AresONE-M 800GE để giả lập các ứng dụng AI và xác nhận hiệu năng của ma trận AI.

Các công cụ này giúp thực hiện đo lường chính xác cho các thao tác tập thể chẳng hạn như all-reduce và all-gather, xác nhận sự sẵn sàng của mạng lưới và giả lập các điểm cuối RoCEv2 để phân tích hiệu năng Queue Pair (luồng dữ liệu AI).

Kiểm thử tự động ma trận AI đánh giá tác động của mạng lên thời gian hoàn thành nhiệm vụ, cô lập hiệu năng, cân bằng tải và kiểm soát tắc nghẽn, đồng thời có thể linh hoạt thử nghiệm các mẫu hình lưu lượng AI thực tế giúp tinh chỉnh cấu hình ma trận.

Tối ưu hóa Ma trận AI cho huấn luyện LLM

Khi các mô hình LLM ngày càng mở rộng, vai trò của quản lý hiệu quả dữ liệu trở nên quan trọng không kém vai trò của công suất tính toán. Ma trận AI cung cấp kết nối nhanh, đáng tin cậy giữa hàng nghìn GPU, tạo liên kết không mất gói dữ liệu với băng thông cao. Tối ưu hóa cơ sở hạ tầng này giúp giảm chi phí huấn luyện và thời gian phát triển AI.

Có thể bạn quan tâm

NVIDIA mở mã nguồn AI dự báo thời tiết Earth-2: Dự đoán bão 15 ngày nhanh gấp 60 lần

Phần mềm - Ứng dụng

AI, robot, Bitcoin và công nghệ sinh học sẽ thay đổi kinh tế toàn cầu

Xu hướng

Meta cắt giảm Reality Labs thổi bùng lo ngại 'mùa đông VR'

AI